DeepSeek是一个强大的推理模型,用户可以通过网页端或者本地部署的方式使用它。由于网页端偶尔存在服务器不稳定的情况,很多用户选择了在本地进行安装和使用。接下来小编将提供具体的步骤和方法,帮助用户顺利完成本地部署并使用DeepSeek。

一、网页端使用

打开官网:

你可以直接访问 DeepSeek 官网 使用网页端。>>官网地址<<

功能:

深度思考: R1 推理模型,可以自动进行思考和推理。

联网搜索: 可用来搜索最新的新闻和内容。

文件处理: 支持图片、文档等文件内容提取,进行文字内容分析。

二、本地安装 DeepSeek R1

如果你选择本地安装 DeepSeek R1,以下是具体步骤:

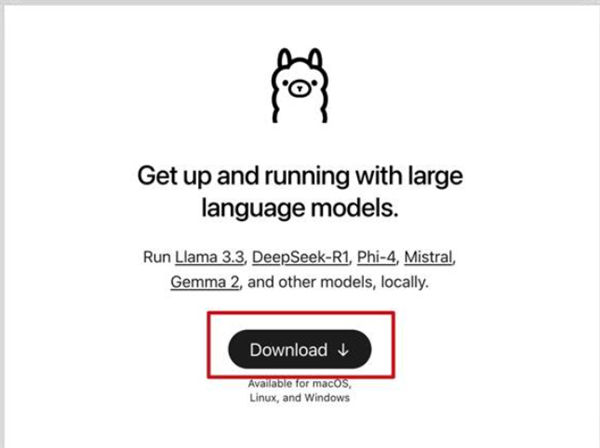

步骤一:安装 Ollama

Ollama 是一个支持多种 AI 模型的工具,我们可以通过它来本地安装 DeepSeek R1 模型。

访问 Ollama 官网: >>点击这里<<

下载并安装: 打开官网,点击下载按钮,将 Ollama 安装到你的本地计算机。

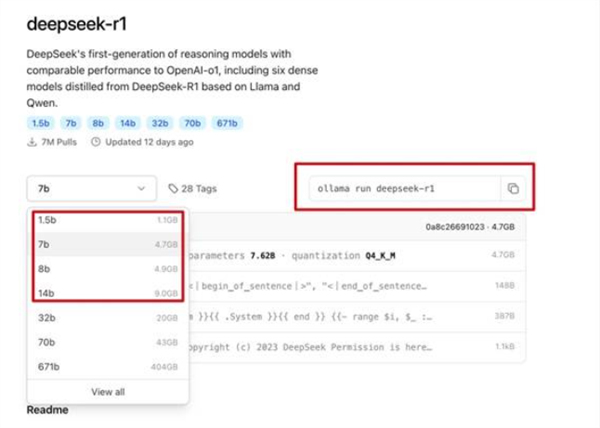

安装模型:

安装完成后,打开 Ollama。

在模型列表中搜索 “DeepSeek R1”。

选择一个模型(如 1.5B、7B),点击安装。

运行模型: 安装成功后,你可以在命令行中输入 ollama list 查看安装的模型。

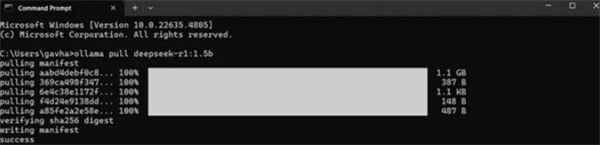

步骤二:使用命令行操作

安装完成后,你可以通过命令行运行模型。输入以下命令来确认安装成功:

输入【ollama list】

步骤三:使用第三方客户端

为了方便操作,你可以使用第三方客户端来连接本地安装的 DeepSeek R1 模型。以下是推荐的客户端:

推荐客户端: Cherry Studio >>Cherry Studio官网<<

Cherry Studio 是一个强大的 AI 客户端,支持多种 AI 模型,并且内置了许多实用功能。

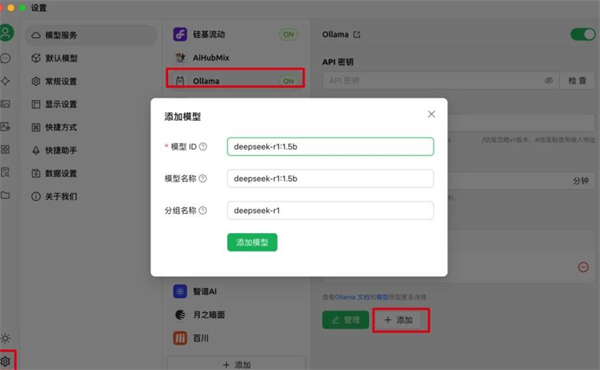

配置 Cherry Studio:

打开 Cherry Studio 客户端,配置 Ollama 安装的模型。

配置时,填入以下信息:

默认API地址: http://localhost:11434/v1

模型名: deepseek-r1:1.5b

步骤四:通过 Cherry Studio 使用模型

在 Cherry Studio 中配置好模型后,你可以直接开始使用 DeepSeek R1 进行各种推理任务。

三、使用第三方 API

如果你没有显卡或者不方便在本地部署 DeepSeek,可以使用第三方 API 服务。以下是一些第三方 API 提供商的选择:

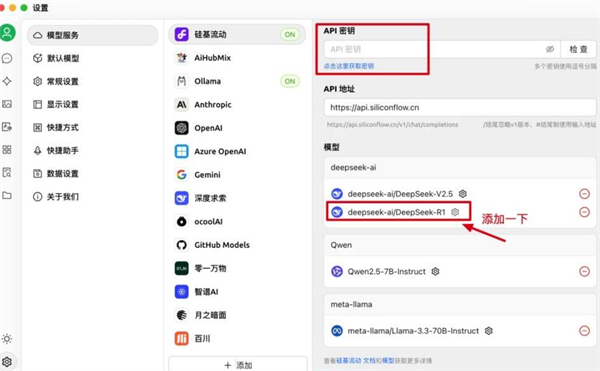

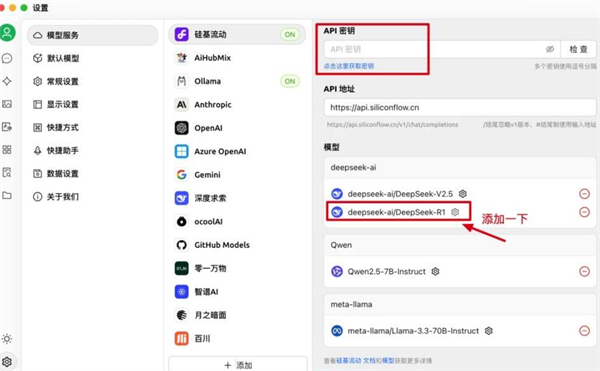

硅基流动(Silicon Flow):

网址:https://cloud.siliconflow.cn

注册账号后,你可以使用免费的 API Key,连接 DeepSeek R1 模型进行使用。

在 Cherry Studio 中配置 API Key 即可使用。

免费 API:

你还可以访问 OpenRouter 网站,找到 DeepSeek R1 的免费 API。

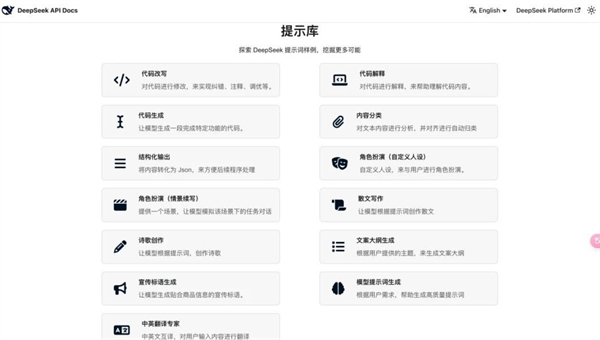

四、提示词库

DeepSeek 官方提供了一个 提示词库,你可以参考其中的提示词进行更加精确的任务执行。>>提示词库网址<<

示例提示词:

大厨风格: “你作为一个大厨,帮我出美食做法教程,包含步骤、注意点、食材和调料,具体到秒。”

产品分析: “你是一个产品专家和设计专家,帮我梳理分析产品需求,并设计 app 原型图。”

通过这些步骤,你可以轻松实现 DeepSeek R1 模型的本地部署,并通过第三方客户端或 API 快速使用。如果你遇到问题,可以参考相关文档或求助于在线社区。

![鸣潮莫特斐怎么玩[多图]](https://pic1.youxiniao.com/youxiniao/imgfile/20240603/03150217vood.jpg)

![鸣潮秧秧怎么玩[多图]](https://pic1.youxiniao.com/youxiniao/imgfile/20240603/031622403737.jpg)

![鸣潮炽霞怎么玩[多图]](https://pic1.youxiniao.com/youxiniao/imgfile/20240531/31155010par7.jpg)

![原神调整棱晶位置与矿石共鸣任务怎么做[多图]](https://pic1.youxiniao.com/youxiniao/imgfile/20240604/041602506zpl.JPG)

![植物大战僵尸杂交版冒险第11关攻略 冒险模式第十一关通关步骤解析[多图]](https://pic1.youxiniao.com/yxn/img2024/5/18/10/2024051898152071.png)